Your Brain on ChatGPT – LLMs sind schlechte (Product-) Coaches

Wie so viele von uns bin ich vor einigen Monaten über das viral-gegangene Pre-print der 2025er "Your Brain on ChatGPT" Studie von Kosmyna et al. gestolpert. In dem Paper wird ein wahres Methodenfeuerwerk gezündet, dessen Ergebnis in groben Zügen besagt, dass Leute, die Texte mit Hilfe von ChatGPT schreiben, wahrscheinlich kognitiv weniger gefordert sind als solche, die die Texte selbst formulieren. Gleichzeitig fühlt sich der finale Text zwar als eigene Arbeit an, daraus zitieren kann man jedoch eher nicht.

Das hat mich zum Nachdenken gebracht: Kann es uns wirklich überraschen, dass der Einsatz eines Chatbots als Antwortmaschine nicht dabei hilft, Wissen zu verankern? Und welche Parallelen bestehen hier zu gutem Coaching und effektiver Wissensvermittlung im Allgemeinen? Lasst mich einmal ausführen, was mir da durch den Kopf geht.

"Your Brain on ChatGPT" – Was wurde erforscht?

Davon abgesehen, dass es mir trotz psychologischer Grundausbildung inhaltlich schwerfallen würde, wirklich alle Details des 206 Seiten langen Papers wiederzugeben, würde dies sicherlich den Umfang dessen sprengen, was ihr hier bereit seid zu lesen. Einen groben Überblick muss ich dennoch geben, damit wir das Experiment diskutieren können, und dabei muss ich tiefer gehen, als es die allgemeine Presse getan hat. Vereinfachend hieß es nämlich beispielsweise im Spiegel "So doof macht uns ChatGPT" (wobei man nichtmal die Studie rezipiert, sondern jemanden interviewt, der darauf verweist), während T-Online reißerisch von "dramatischen Erinnerungslücken" spricht. Wie so häufig haben die Forschenden weniger heiß gekocht, als es in der Clickbait-Produktion gegessen wird.

Was in der Studie eigentlich untersucht wurde, ist das Folgende: Man hat Probanden in drei Gruppen eingeteilt, die jeweils 20 Minuten Zeit hatten, um in mehreren Sitzungen Essays zu schreiben. Die erste Gruppe – Brain Only – hatte dafür nur ihren eigenen Kopf zur Verfügung. Die zweite Gruppe – Search Engine – durfte Google zur Recherche verwenden (ohne "Übersicht mit KI-Feature" natürlich) und der dritten Gruppe – LLM – war es erlaubt, ChatGPT beim Schreiben zu nutzen.

Über verschiedene Runden wurden so verschiedene Essays produziert, jeweils kontrolliert durch und begleitet von diversen Methoden. Im Ergebnis hat man dann festgestellt, dass die Brain Only Gruppe die höchste messbare kognitive Anstrengung leisten musste und sich am besten an ihre eigenen Essays erinnern konnte. Die Search Engine Gruppe lag in der Mitte und die LLM Gruppe wiederum war kognitiv am wenigsten gefordert und konnte sich deutlich schlechter als die beiden anderen Gruppen an Zitate aus den eigenen Essays erinnern. Spannenderweise ist die Identifikation mit der eigenen Arbeit in allen drei Gruppen stark. Es ist also nicht so, dass die LLM Gruppe das Gefühl gehabt hätte, keine Arbeit geleistet zu haben. Die AutorInnen besprechen in der Diskussion der Ergebnisse dann vor allem die Gefahr, in der LLM-Nutzung kognitive Schuld ('cognitive debt') aufzubauen, womit gemeint ist, dass wir vermehrt Konzepte nutzen, die wir eigentlich nicht voll verstanden haben, was in Akkumulation ein Problem für unsere autonome Handlungsfähigkeit sein könnte.

Die Studie im Kontext: Binsenweisheiten oder hilfreiche Einsichten?

Was verrät uns dieses Ergebnis nun wirklich über den Effekt von LLMs auf unsere kognitive Leistungsfähigkeit? Die Übertragbarkeit auf den Alltag ist mindestens begrenzt! Der erste Punkt ist, dass 54 Probanden mit ähnlicher Demographie bei einer begrenzten Aufgabe nicht dafür geeignet sind, weitreichende Aussagen zu treffen, sondern lediglich eine Indikation für weitere Forschung vorgeben, wie die AutorInnen natürlich selbst anmerken.

Ein zweiter Punkt ist jedoch viel wichtiger und wurde von den Forschenden leider nicht deutlich markiert: Das experimentelle Design erfasst nur eine spezifische Art der LLM-Nutzung. Die LLM-Gruppe bestand im Wesentlichen aus "Copy & Paste Warriors", die sich unter Zeitdruck nicht mit dem Inhalt befassten, sondern fertige Antworten übernahmen.

Wir vergleichen hier also drei Gruppen, von denen zwei ein Essay produziert haben und eine eines hat produzieren lassen. Von denen zwei über den Inhalt nachgedacht haben und eine hat nachdenken lassen. In diesem Design fallen mir viele weitere Faktoren ein, die einen deutlich größeren Effekt auf mein kognitives Engagement haben, und ich bin mir sicher, das Ergebnis wäre deutlich anders ausgefallen, wenn beispielsweise das Ziel nicht gewesen wäre, unter Zeitdruck ein Essay zu verfassen, sondern ein tiefes Verständnis über ein Thema zu gewinnen.

So wie das Experiment gestaltet wurde haben wir aber weniger darüber gelernt, was LLMs mit uns kognitiv machen, als darüber, dass man beim bloßen Kopieren nichts dazulernt – eine Weisheit die man eigentlich schon beim Abschreiben der Hausaufgaben im Schulbus gelernt haben sollte.

Die Studie liefert dennoch wertvolle erste Erkenntnisse: Sie zeigt empirisch, was wir intuitiv vermuten, und identifiziert einen wichtigen psychologischen Effekt: die starke Identifikation mit fremdproduziertem Content. Diese Selbstüberschätzung könnte langfristig problematischer sein als das reine Kopieren selbst, insbesondere vor dem Hintergrund, dass uns das eigene Unvermögen dabei nicht bewusst sein muss.

Gute Coaches vs. schlechte Coaches

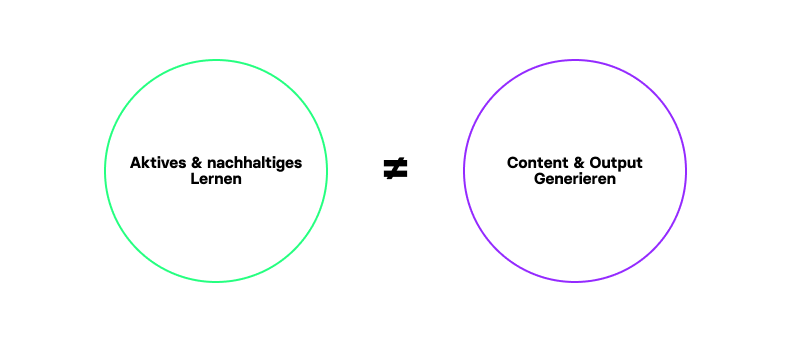

Also, fassen wir zusammen: Dinge einfach ohne Gedanken nachzumachen stärkt uns kognitiv nicht. Nicht beim Produzieren eines Essays und auch nicht beim Abschreiben von Hausaufgaben. Lasst uns diesen Gedanken einmal mit Bezug auf Coaching in den Fokus fassen. Es gilt: Schlechte Coaches geben Antworten, gute Coaches stellen Fragen, die dir helfen, selbst auf die richtigen Antworten zu stoßen.

Das tun gute Coaches einerseits deswegen, weil sie die beste Antwort häufig selbst nicht kennen. Sogar in Fällen, in denen man in Fachwissen und Erfahrung weit überlegen ist, ist der Coachee (also derjenige, der gecoacht wird) doch immer noch Experte für die eigene Situation, deren Kontext die Lehrbuch-Antwort verändert. Antworten sind also höchstens Angebote, die es gemeinsam auf die Passung für den individuellen Fall hin zu bewerten gilt.

Es gibt jedoch hinter dem Thema der Haltung noch einen viel wichtigeren Aspekt, weshalb gute Coaches nur selten Antworten geben: Wir lernen früh und schnell, dass klare Antworten sich zwar kurzfristig gut anfühlen mögen, jedoch dem eigentlichen Ziel von ethischem Coaching – die Coachees nach möglichst kurzer Zeit vom Coaching unabhängig zu machen und ihre Ressourcen zu stärken – diametral entgegenlaufen.

Der Grund dafür findet sich im selben Mechanismus, weshalb LLMs uns nicht kognitiv fordern: Man muss die Dinge selbst durchdenken, um sie effektiv ins eigene Denken zu übernehmen. Ansonsten findet kaum Lernen statt. Nur wenn man selbst das Für und Wider verschiedener Ansätze durchdacht hat, kann man damit weiterarbeiten und darauf aufbauen. Coaches, von deren regelmäßigen Ratschlägen wir abhängig werden sind genauso schlecht, wie ein langsames Abdriften in gedankenloses Output-Prompting.

Wie kann ich durch LLMs (wahrscheinlich) nachhaltig schlauer werden?

Nehmen wir damit einmal als gegeben an, dass die kognitiv wenig geforderte LLM Gruppe nicht wegen der Natur von LLMs selbst verkümmert ist, sondern weil sie LLMs unter Zeitdruck als Hausaufgaben-Abschreiber verwendet hat – welchen Schluss kann man daraus ziehen, um diesem Effekt entgegenzuwirken?

Die Antwort liegt darin, LLMs wie einen guten Coach zu nutzen anstatt wie einen schlechten. Das bedeutet konkret: Nutze sie zur Generierung von Fragen und Denkansätzen, nicht zur Produktion fertiger Antworten, von denen ich langfristig abhängig werde. Meine drei Strategien dazu:

Die erste Strategie ist, beim Reflektieren von komplexen Problemen erst spät mit LLMs zu arbeiten, auch wenn die strukturierende Form verlockend ist. Es ist für die Entwicklung des eigenen Denkens von unglaublichem Vorteil, sich erst einmal in Ruhe hinzusetzen und langsam zu durchdenken, welche Probleme man sieht, wie ein geeignetes Zielbild aussieht und wie sinnvolle erste Schritte aussehen können. Erst wenn man kognitiv anstrengende Arbeit einmal geleistet hat, lohnt sich der Austausch mit einem Chatbot – zumindest wenn man den Anspruch hat, Ownership für das Ergebnis der Arbeit zu übernehmen und nicht einfach schnell Output generieren will.

Die zweite Strategie ist, LLMs gezielt zur Generierung von Fragen anstelle von Antworten zu nutzen. Prompte beispielsweise nicht "Wie kann ich mit meinem Stakeholder gut umgehen?", sondern beschreibe in Ruhe für dich selbst, welche Probleme du mit deinen Stakeholdern siehst, wie ein Zielbild aussieht und was dein erster Schritt wäre, und nutze dies als Input für einen Prompt, in dem du gezielt fragst: "Was könnte in meiner Beschreibung ein blinder Fleck sein?". Die dabei herauskommende Antwort regt dein Denken weiter an, ohne es abzuschließen. Ein angenehmer Nebeneffekt dabei ist auch, dass eine Schwäche von LLMs damit nicht zutage tritt: die Tendenz, zu wenig über Kontext in Erfahrung zu bringen.

Die dritte Strategie wäre, bei allem Experimentieren nicht den Austausch mit Menschen aus den Augen zu verlieren. Mir fällt da für Start-up und Produktthemen beispielsweise ein guter Coach ein. Jetzt kostenlos Termin zum Kennenlernen mit Jan Hoppe buchen. 🙃 Aber es muss ja nicht direkt ein Profi sein. Geht in den Kontakt, lernt von Menschen und nehmt den Nebeneffekt mit, dass der Austausch mit Menschen uns guttut: Die Einsamkeitsbelastung ist beispielsweise nicht mehr auf dem 30%-Stand von 2020, aber mit 10-15% immer noch deutlich über dem Niveau vor der Pandemie. Die wechselseitige Unterstützung hilft euch also nicht nur bei offenen Fragen, sondern hilft eurem Wohlbefinden langfristig. Lasst uns das bei aller Technologiebegeisterung nicht vergessen.

Was haben wir also über das Lernen mit LLMs gelernt?

Generative-AI-Chatbots sind Werkzeuge, die wir in unserer digitalen Produktarbeit verschieden nutzen können. Wir können unsere Arbeit dadurch stärken oder teilweise outsourcen. Ebenso wenig, wie wir uns wundern, wenn eine Führungskraft die Details der eigenen Abteilung nicht versteht, wenn diese nur Aufgaben verteilt und die Teammitglieder sonst sich selbst überlässt, sollten wir uns wundern, wenn ein kurz geprompteter und dann kopierter GPT-Output keine Kompetenzsteigerung darstellt. Je nach Situation sollten wir Gen-AI folglich mal wie einen Mitschüler behandeln, dessen Hausaufgaben kopiert werden – und mal als Lehrperson, der wir mit durchdachten Fragen entgegentreten und die uns auf neue Gedanken stoßen kann.